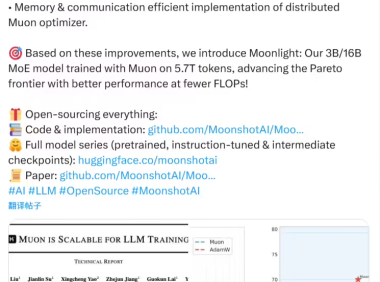

2 月 24 日消息,月之暗面Kimi昨日发布了“Muon 可扩展用于 LLM 训练”的新技术报告,并宣布推出“Moonlight”:一个在 Muon 上训练的 30 亿 / 160 亿参数混合专家模型(MoE)。使用了 5.7 万亿个 token,在更低的浮点运算次数(FLOPs)下实现了更好的性能,从而提升了帕累托效率边界。月之暗面称,团队发现 Muon 优化器可通过添加权重衰减、仔细调整每个参数的更新幅度等技术进行扩展,并具备如下亮点:这些技术使得 Muon 能够在大规模训练中开箱即用,无需进行超参数调优。扩展法则实验表明,与计算最优训练的 AdamW 相比,Muon 实现了约 2 倍的计算效率。本次论文所使用的模型为 Moonlight-16B-A3B,总参数量为 15.29B,激活参数为 2.24B,其使用 Muon 优化器,在 5.7T Tokens 的训练数据下获得上述成绩。我们的模型不仅突破了当前的 Pareto 前沿,还在训练所需的 FLOP 数大幅减少的情况下,达到了比以往模型更优的性能。我们开源了一个分布式版本的 Muon 实现,它在内存使用和通信效率上都进行了优化。同时,我们也发布了预训练模型、经过指令调优的模型以及中间训练检查点,旨在为未来的研究提供支持。附有关链接如下:GitHub:点此前往Hugging Face :点此前往相关内容:月之暗面发布 Kimi 探索版:搜索量相比普通版增强 10 倍,可精读 500 个页面月之暗面 Kimi 创始人杨植麟称 AI 人才回流大厂是行业规律,已主动做业务减法Kimi 数学版上线:基于月之暗面 k0-math 模型,号称能力对标 OpenAI o1月之暗面 Kimi 联合清华大学等开源大模型推理架构 Mooncake声明:内容来源公开的各类媒体平台,若收录的内容侵犯了您的权益,请联系邮箱,本站将第一时间处理。

常见问题